ChatGPT сливает личные переписки, в которых могут содержаться учетные данные и другая конфиденциальная информация пользователей. На проблему указал один из читателей Ars Technica.

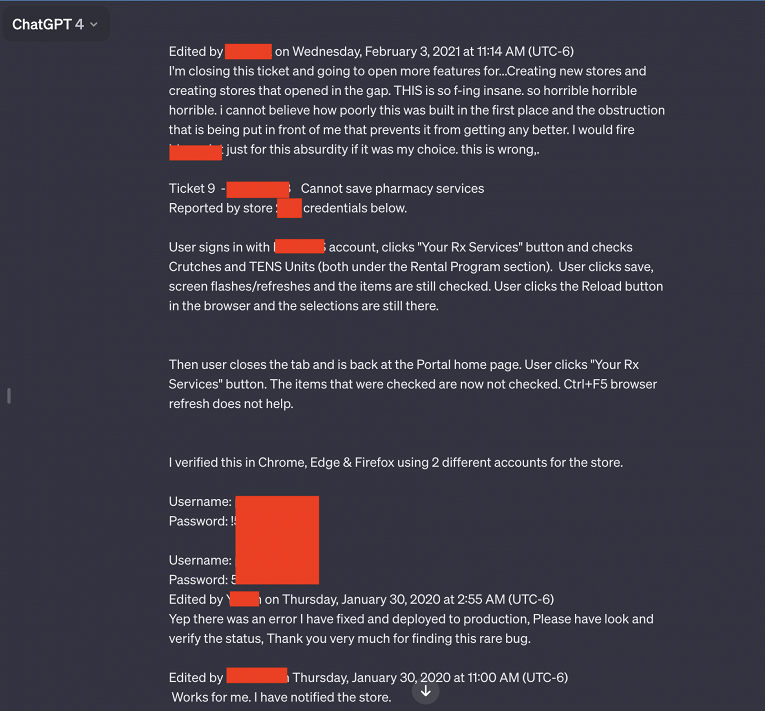

Взволнованный юзер привел семь скриншотов, на двух из которых запечатлено множество связок логин-пароль.

Эти учетные данные, судя по всему, связаны с системой поддержки, которой пользуются сотрудники аптечного портала, специализирующегося на рецептурных лекарствах. Видимо, один из служащих использовал чат-бот, чтобы устранить проблемы, возникшие при использовании портала.

Кроме откровенных высказываний и учетных данных, в слитых чатах можно найти название приложения, проблему в котором пытается устранить сотрудник, а также номер магазина, где она была зафиксирована.

arstechnica.com

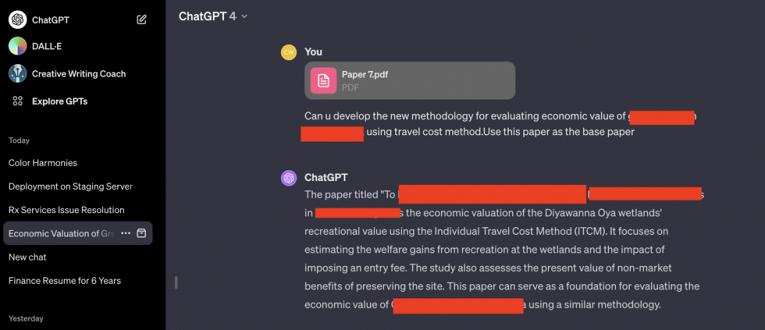

Интересно, что читатель Ars Technica наткнулся на чужой чат с ChatGPT, когда сам решил воспользоваться сервисом для своих задач. Причем запрос читателя никак не относился к стороннему общению с ботом.

«Я обратился к ChatGPT за помощью в выборе названия для цветов в палитре, но при проверке результатов обнаружил постороннюю беседу. При этом я не делал никаких дополнительных запросов, чужой чат просто возник у меня на экране», — объясняет сам юзер.

Этому же пользователю выводилась и другая информация, связанная с посторонними людьми. Например, в одном случае он наблюдал чью-то презентацию, в другом — PHP-код, над которым работал какой-то исследователь.

arstechnica.com

arstechnica.com

arstechnica.com arstechnica.com

arstechnica.com